Bienvenue dans ce cycle de trois articles sur l’Intelligence Artificielle (IA) et son rapport à l’éthique. L’IA, seulement deux lettres et pourtant de multiples interrogations à tout-va. Vous devez avoir déjà une idée plus ou moins précise de ce qu’est l’IA. Ce que nous vous proposons maintenant, c’est de mettre en avant les limites de l’IA face à la morale.

Ce mois-ci nous commençons avec l’explicabilité des modèles

1/ Expliquer les modèles

2/ Diminuer la discrimination (l’article publié le 19 Avril 2022)

3/ Trouver des solutions (article publié le 17 mai 2022)

Imaginons que vous demandiez un prêt à une banque, et que vous vous voyez refuser celui-ci. Votre première question sera “pourquoi ?”.

Et si je vous dis que grâce à cet article, vous allez comprendre comment il est possible d’y répondre 🎯

Qu’est-ce qu’un algorithme de Machine Learning ?

Avant de rentrer dans le vif du sujet, un petit rappel de ce qu’est un modèle de Machine Learning.

Pour faire simple 🐣, c’est :

- une forme d’Intelligence Artificielle

- qui permet à un système d’apprendre à partir de données

- basé sur un algorithme (une suite d’opérations)

Les modèles de Machine Learning permettent de faire des choses aussi incroyables que détecter un cancer, paramétrer votre Siri ou encore conduire une voiture autonome.

Ceci étant posé, avez-vous une idée de comment fonctionne un algorithme de Machine Learning ? Et pourquoi cela est-il important ?

Reprenons l’exemple du prêt à la banque qui vous aurait été refusé. Dans une telle situation, vous souhaiteriez comprendre quels sont les paramètres qui ont influencé le modèle de Machine Learning pour que celui-ci vous catégorise comme “non solvable”.

Si le modèle choisi est dit “whitebox”, cela peut se voir aisément; si le modèle est “black box”, cela est plus compliqué et c’est là-dessus que nous allons nous attarder.

(Pour plus de détail sûr ce qu’est un modèle facilement interprétrable dit “white box” et un modèle “black box” ou boîte noire, référez-vous à la fin de l’article.)

L’explicabilité d’un modèle “Blackbox”

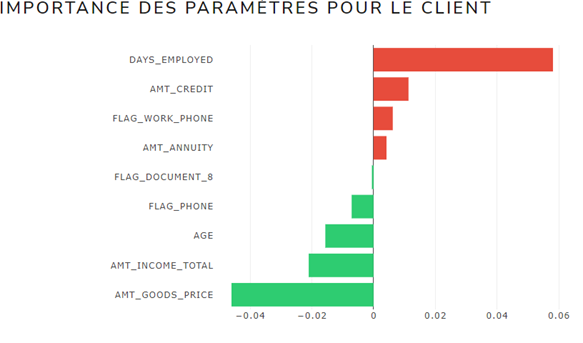

Passons directement à la pratique pour avoir une idée plus précise de ce qu’est l’explicabilité d’un modèle “blackbox”. Restons sur cet exemple de prêt à la banque.

Il existe un modèle permettant d’identifier les paramètres qui ont influencé une décision pour un client en particulier, vous en l’occurrence (interprétation locale). Ce modèle est appelé le Lime Explainer.

Sur le graphique ci-dessus, vous pouvez voir par exemple que le critère “Days employed” (ancienneté) influence le plus négativement la décision : ainsi, vous êtes dans votre nouveau poste depuis trop peu de temps ! À l’inverse, votre âge est un critère qui joue en votre faveur.

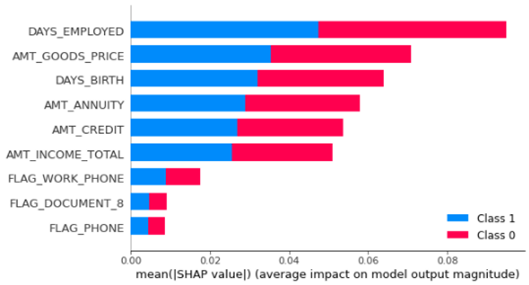

Pour aller plus loin, il est aussi possible de comparer l’influence des paramètres pour un client en particulier en le comparant aux clients ayant des profils similaires (interprétation globale). Ce modèle d’interprétation s’appelle le Shap Explainer.

Ci-dessous, vous pouvez voir l’influence de chaque paramètre sur la classe 0 (solvable) et la classe 1 (non solvable).

On retrouve ici par exemple que l’ancienneté est un critère déterminant, surtout pour ceux catégorisés comme non solvable.

Les limites des modèles explicatifs

Néanmoins, il faut relever les limites de ces modèles explicatifs qui peuvent parfois être contre-productifs en créant une confiance absolue dans le système. Ils doivent avant tout être vus comme des compléments et garder en tête que leur rôle principal est de :

- Valider la cohérence du modèle

- Donner confiance aux équipes métier sur le choix du modèle

- Permettre aux équipes métier de justifier les décisions auprès des clients

- Augmenter la transparence

Voilà une introduction à l’explicabilité d’un modèle. Pour les data experts qui veulent approfondir le sujet, je vous invite à continuer cette lecture, pour les autres, merci et RDV le mois prochain pour parler de discrimination dans les algorithmes 👀

************************* BONUS DATA EXPERT ***************************

Distinction modèle white/black box

Modèles white box :

- Régression linéaire

- Régression logistique

- Arbres de décision

- Knn

Modèles black box :

- réseaux de neurones

- gradient boosting

Pour une mise en pratique :

https://www.aquiladata.fr/insights/interpretabilite-des-modeles-de-machine-learning/

[…] Expliquer les modèles (article publié le 31 mars […]